Giovedì OpenAI ha presentato ufficialmente GPT-5.2, il suo modello più avanzato fino ad oggi. La nuova versione è stata presentata dopo che l’azienda era entrata – usando le parole dello stesso Altman – in modalità “codice rosso”, in seguito al calo di traffico di ChatGPT rispetto al suo principale competitor, Gemini.

Il nuovo sistema, almeno inizialmente, sarà disponibile solo per gli abbonati a ChatGPT e per gli sviluppatori che accedono all’AI tramite API. In totale, sono disponibili tre versioni: Instant, ottimizzato per velocità in query di routine come ricerca informazioni, scrittura e traduzione; Thinking, eccellente per lavori strutturati complessi come programmazione, analisi di documenti lunghi, matematica e pianificazione; e Pro, il modello top di gamma pensato per massima accuratezza e affidabilità nei problemi difficili.

La risposta al “codice rosso”

All’inizio del mese, The Information ha rivelato che il CEO Sam Altman aveva diffuso un memo interno annunciando ai dipendenti di OpenAI che l’azienda era ufficialmente entrata in modalità “codice rosso”. Il motivo? ChatGPT aveva iniziato a perdere terreno rispetto a Gemini, l’AI di Google. Altman era terrorizzato dall’idea che OpenAI potesse perdere ulteriori quote di mercato a favore del competitor.

Nella comunicazione, Altman raccomandava allo staff un cambio delle priorità, rinviando qualsiasi progetto secondario (tra cui la chiacchierata e contestata introduzione delle pubblicità) per concentrare tutte le risorse sul miglioramento delle performance di ChatGPT. GPT-5.2, insomma, è la risposta a questa urgenza: secondo diverse fonti, il lancio del nuovo modello sarebbe stato spinto in anticipo, nonostante le proteste di alcuni dipendenti che avevano chiesto più tempo per migliorarlo.

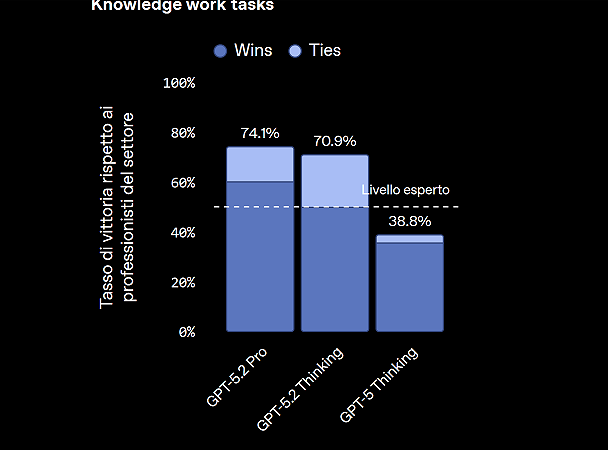

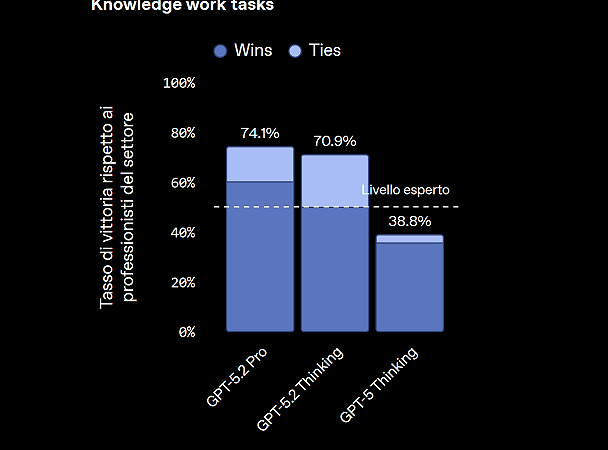

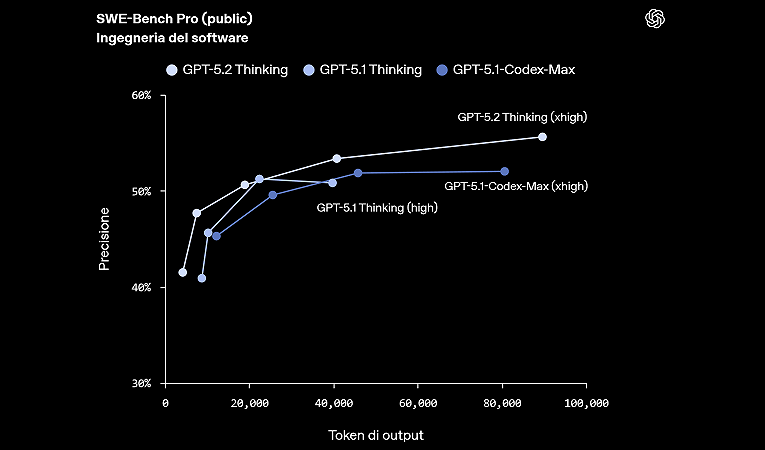

Il modello stabilisce nuovi punteggi record in programmazione, matematica, scienze, visione e ragionamento su contesti lunghi; capacità che secondo l’azienda potrebbero portare a maggiore capacità di automazione dei flussi di lavoro, una maggiore qualità nei lavori di programmazione e, quindi, maggiore capacità di lavorare su vasti contesti, analizzandone i dati in tempo reale. Si tratta di ambiti professionali, più rivolti al mondo enterprise e della ricerca scientifica, che a quelli che tipicamente interessano l’utente medio di ChatGPT.

Una strategia molto costosa

La rinnovata attenzione di OpenAI sui modelli di ragionamento rappresenta una scommessa rischiosa. I sistemi dietro le modalità Thinking e Deep Research sono più costosi da eseguire rispetto ai chatbot standard perché consumano più potenza di calcolo.

Puntando su questo tipo di modello con GPT-5.2, OpenAI potrebbe creare un ciclo vizioso: spendere di più in calcolo per vincere la classifica, poi spendere ancora di più per mantenere questi modelli ad alto costo operativi su larga scala. OpenAI starebbe già spendendo più in calcolo di quanto precedentemente dichiarato, con la maggior parte della spesa per l’inferenza pagata in contanti anziché tramite crediti cloud.

Insomma, gira e rigira, il problema di queste grandi aziende AI è sempre lo stesso: non solo i costi sono già altissimi, ma sono anche una frazione della spesa complessiva che programmano di spendere nei prossimi anni per potenziare le infrastrutture e rimanere competitive. Le prospettive di profitto, nel frattempo, rimangono molto remote: nel caso di OpenAI, che prevede di spendere 1.400 miliardi di dollari nel corso dei prossimi anni, le stime ottimistiche suggeriscono che i primi profitti arriveranno solamente dopo il 2030.

Openai, GPT 5.2 è un mostro di potenza: tutto quello che devi sapere sull’AI è stato pubblicato per la prima volta su Lega Nerd. L’utilizzo dei testi contenuti su Lega Nerd è soggetto alla licenza Creative Commons Attribuzione-Non commerciale-Non opere derivate 2.5 Italia License. Altri articoli dello stesso autore: Umberto Stentella